Können Kinder auch anders schützen: iCloud-Kinderporno-Scanner von Apple offiziell beerdigt

Apple hat ein höchst umstrittenes Programm für einen wirksameren Schutz von Kindern vor sexueller Ausbeutung beerdigt. Die Suche nach Kinderporno-Inhalten in iCloud-Fotos wird nicht kommen, das hat Apple heute bestätigt. In diesem Zusammenhang kam das Unternehmen zu einer wichtigen Erkenntnis.

Das dürfte Sicherheitsforscher, Datenschützer und Bürgerrechtsaktivisten aufatmen lassen: Einer von Apples umstrittensten Plänen ist vom Tisch. Apple wird die iCloud-Fotos seiner Nutzer nicht automatisiert nach Kinderporno-Inhalten durchsuchen, das bestätigte ein Unternehmenssprecher gegenüber WIRED.

Die Einführung der Funktion war bereits zuvor auf unbestimmte Zeit ausgesetzt worden, nun ist sie endgültig abgesagt.

Apple: Können Kinder schützen, ohne personenbezogene Daten zu sammeln

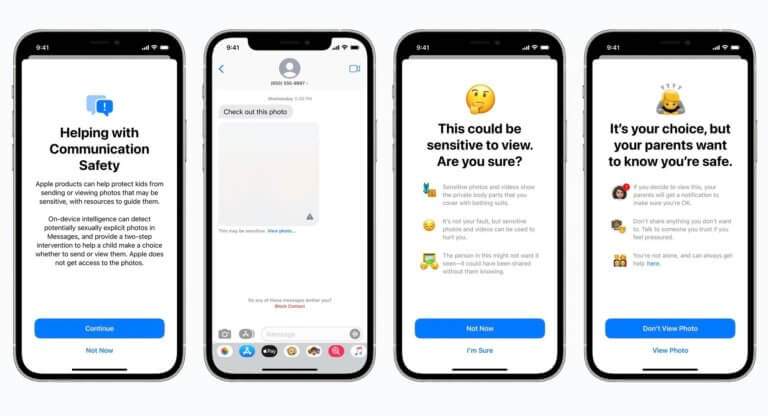

Nach intensiven Konsultationen mit Kinderschutzorganisationen und Initiativen habe Apple sich entschieden, einerseits seine Investitionen in effektive Schutzmaßnahmen wie das Kommunikationssicherheitsfeature zu verstärken, andererseits aber die umstrittene CSAM-Erkennung nicht einzuführen.

Kinder können auch geschützt werden, ohne das Unternehmen personenbezogene Daten von Kunden durchwühlen, so der Sprecher weiter. Die Funktion war nicht nur von Sicherheitsforschern höchst kritisch gesehen worden, auch aus der Politik und den Medien und sogar aus Apples eigenen Reihen war Sorge und Kritik zu vernehmen gewesen.

Aktiv bleibt dagegen die Kommunikationssicherheit in iMessage: Sie soll dafür sorgen, dass Kinder nicht mit Nacktfotos konfrontiert werden und auch selbst nicht ungebremst solche Aufnahmen verschicken. Der Filter ist allerdings deutlich weniger invasiv, birgt kein gefährliches Missbrauchs- oder Fehlerpotenzial und ist – das muss angemerkt werden – aufgrund seiner Beschränktheit auf iMessage und die weiteren Nutzungsvoraussetzungen wohl ohnehin weitgehend bedeutungslos.

Das Ende für den Kinderporno-Scanner fällt mit der Ankündigung einer voll ausgebauten Ende-zu-Ende-Verschlüsselung für die iCloud zusammen.

Zusammenfassend lässt sich sagen: Heute ist ein guter Tag für den Datenschutz bei Apple und darüber hinaus.

-----

Willst du keine News mehr verpassen? Dann folge uns auf Twitter oder werde Fan auf Facebook. Du kannst natürlich in Ergänzung unsere iPhone und iPad-App mit Push-Benachrichtigungen hier kostenlos laden.

3 Kommentare zu dem Artikel "Können Kinder auch anders schützen: iCloud-Kinderporno-Scanner von Apple offiziell beerdigt"

3 Kommentare zu dem Artikel "Können Kinder auch anders schützen: iCloud-Kinderporno-Scanner von Apple offiziell beerdigt"

-

WolfgangD. 8. Dezember 2022 um 19:12 Uhr ·„Apple wird die iCloud-Fotos seiner Nutzer nicht automatisiert nach Kinderporno-Inhalten durchsuchen“ Damit hat man indirekt gesagt, man verzichtet nicht auf das Durchschnüffeln auf Raubmordterrorkopien nach DMCA in Text Ton Bild, US-Spionage, und nackte Brustwarzen. Same Crap wie Microsoft Onedrive oder Google Drive. Da ändert auch eine Transportverschlüsselung (End-To-End) wenig, wenn der hauseigene Messenger weiterhin ganz offen auf Hautbilder überwacht wird. Nicht wahr? Was für ein verlogener Laden.

iLike 0

iLike 0 -

Alex 8. Dezember 2022 um 20:26 Uhr ·Selten so ein Haufen Schwachsinn gelesen. Du glaubst sicher auch den ganzen Politikern und Medien, oder?

iLike 0

iLike 0 -

WolfgangD. 9. Dezember 2022 um 23:50 Uhr ·@Alex So widersprüchlich wie du formulierst, scheinst eher du verwirrt. Oder kannst nicht Lesen und Verstehen, was nach jüngsten Untersuchungen bei euch Jungvolk bei über 40% passiert.

iLike 0

iLike 0

-

-