Apple hat eine Reihe neuer Maßnahmen zum Schutz von Kindern vor Belästigung und sexuellen Übergriffen angekündigt. Diese neuen Mechanismen nutzen maschinelles Lernen und untersuchen unter anderem Fotos direkt auf den Geräten der Nutzer. Die Umsetzung ist dabei technisch sehr anspruchsvoll.

Apple hat eine neue umfangreiche Initiative für besseren Schutz von Kindern angekündigt, die Apple-Produkte wie ein iPhone nutzen. Kinder sollen so etwa vor Darstellungen sexueller Handlungen und sexueller Ausbeutung geschützt werden.

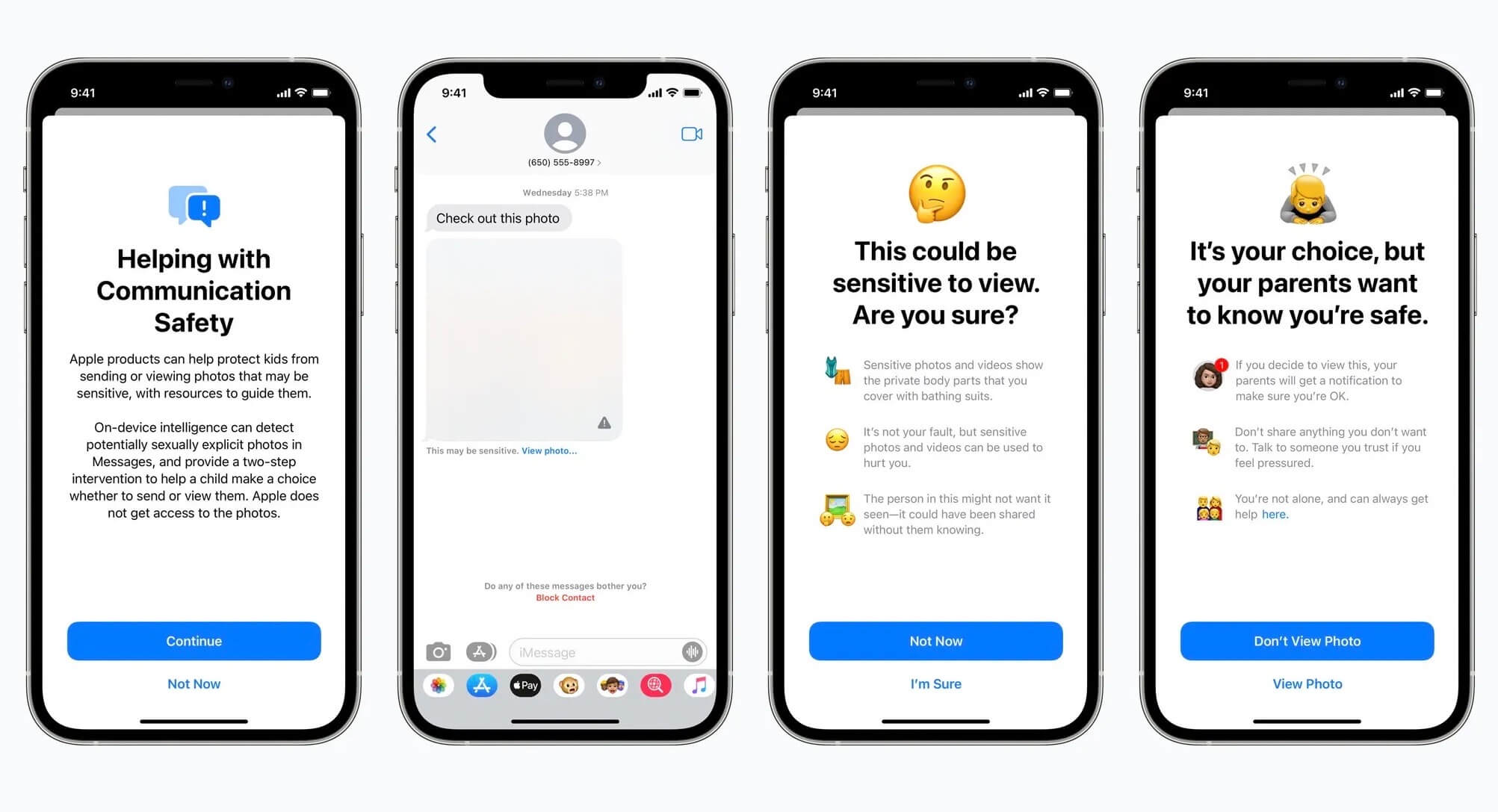

Die Umsetzung erfolgt auf verschiedenen Wegen: Einerseits greifen die neuen Schutzmaßnahmen direkt in iMessage: Wenn Kinder bis 13 Jahren versuchen, Bilder mit eindeutigen sexuellen Inhalten zu versenden, erhalten sie eine Warnmeldung. Sollten sie sich entscheiden, das Bild dennoch zu senden, erhalten die Eltern eine entsprechende Benachrichtigung.

Wenn Bilder mit sexuellen Darstellungen an Kinder zugestellt werden, werden diese zunächst unscharf dargestellt. Das Kind erhält eine Benachrichtigung, in der es darauf hingewiesen wird, dass das Foto sensible Motive zeigen kann. Auch hier kann das Kind das Bild anzeigen, es wird allerdings darauf hingewiesen, dass die Eltern hierüber informiert werden.

Das setzt voraus, dass Kinder und Eltern in der selben iCloud-Familie organisiert sind.

Automatische Suche nach sexuellem Missbrauch

Eine weitere und vielleicht noch bedeutendere Neuerung ist ein automatischer Abgleich zur Suche von Bildern, die sexuelle Handlungen mit Kindern zeigen. Microsoft hat sich schon lange als Vorreiter auf diesem Gebiet etabliert und dessen Technologie Photo DNA kommt bereits seit Jahren in den Lösungen verschiedener Unternehmen wie etwa Cloud-Hostern zum Einsatz. Die Technik von Apple ist ähnlich aufgebaut, jedoch in den Details noch etwas komplizierter.

Im Kern läuft ein Abgleich mit einer Datenbank, die einen Index bekannter Bilder und Bildkomponenten führt. Fotos von Nutzern eines iPhones oder Macs werden auf Übereinstimmungen mit dieser Datenbank hin geprüft, doch hier hat Apple einigen Aufwand getrieben, um die Privatsphäre zu schützen. Der Abgleich erfolgt zunächst anonymisiert und lokal auf den Geräten der Nutzer. Zudem wird nicht unmittelbar bei Entdeckung einer Übereinstimmung eine Aktion ausgelöst. Viel mehr nutzt Apple hier einen Schwellenwert, der auf recht undurchsichtige Weise festlegt, ab wann laut Apple Handlungsbedarf entsteht. All diese Schritte erfolgen MachineLearning-basiert und voll automatisch auf den Geräten der Nutzer, bevor Bilder zur iCloud übertragen werden. Wird der kritische Schwellenwert überschritten, wird der entsprechende Vorgang manuell durch Mitarbeiter von Apple überprüft.

Der iCloud-Account des Kunden wird sodann deaktiviert und das National Center for Missing and Exploited Children, bei dem auch die zugrundeliegende Datenbank geführt wird, wird informiert. Apple erklärt, das genutzte Modell schließe versehentliche Sperrungen von Accounts nahezu sicher aus, dennoch können Nutzer im Anschluss eine Kontaktmöglichkeit nutzen, um im Falle eines Fehlers wieder Zugang zu ihrem Account zu erhalten.

Wann und wo starten die neuen Features?

Diese Neuerungen werden als Teil von iOS 15 und macOS Monterey später im Jahr ausgerollt, aber zunächst nur in den USA. Wann und in welchen weiteren Märkten sie darüber hinaus starten werden, bleibt einstweilen unklar.

7 Gedanken zu „Kinder vor sexueller Ausbeutung schützen: Apple kündigt umfassende Maßnahmen an“

Die Kommentare sind geschlossen.