Eine kürzlich eingereichte Klage will Apple zwingen, schärfer gegen den Vertrieb von Missbrauchsinhalten auf seiner Cloud-Plattform iCloud vorzugehen. Das Unternehmen wird in den USA beschuldigt, trotz Wissens um ein gravierendes Problem mit Kindesmissbrauchsmaterial (Child Sexual Abuse Material, CSAM) untätig geblieben zu sein.

Die Klage wurde im Namen einer 9-jährigen Klägerin eingereicht, die nach eigenen Angaben Opfer von Kindesmissbrauch wurde. Unbekannte hätten sie über iMessage dazu gebracht, CSAM-Inhalte von sich selbst zu erstellen und diese über iCloud zu teilen.

Klage über fehlende Maßnahmen, die Apple aus Datenschutzgründen nicht implementierte

Im Mittelpunkt der Klage steht die Tatsache, dass Apple seine iCloud-Inhalte nicht auf CSAM scannt, obwohl es dafür verfügbare Technologien wie PhotoDNA gibt, die von anderen Cloud-Anbietern genutzt werden. Die Klägerin fordert, dass Apple eine Meldefunktion für verschlüsseltes Material integriert und die Verbreitung von Missbrauchsinhalten auf seiner Plattform eindämmt.

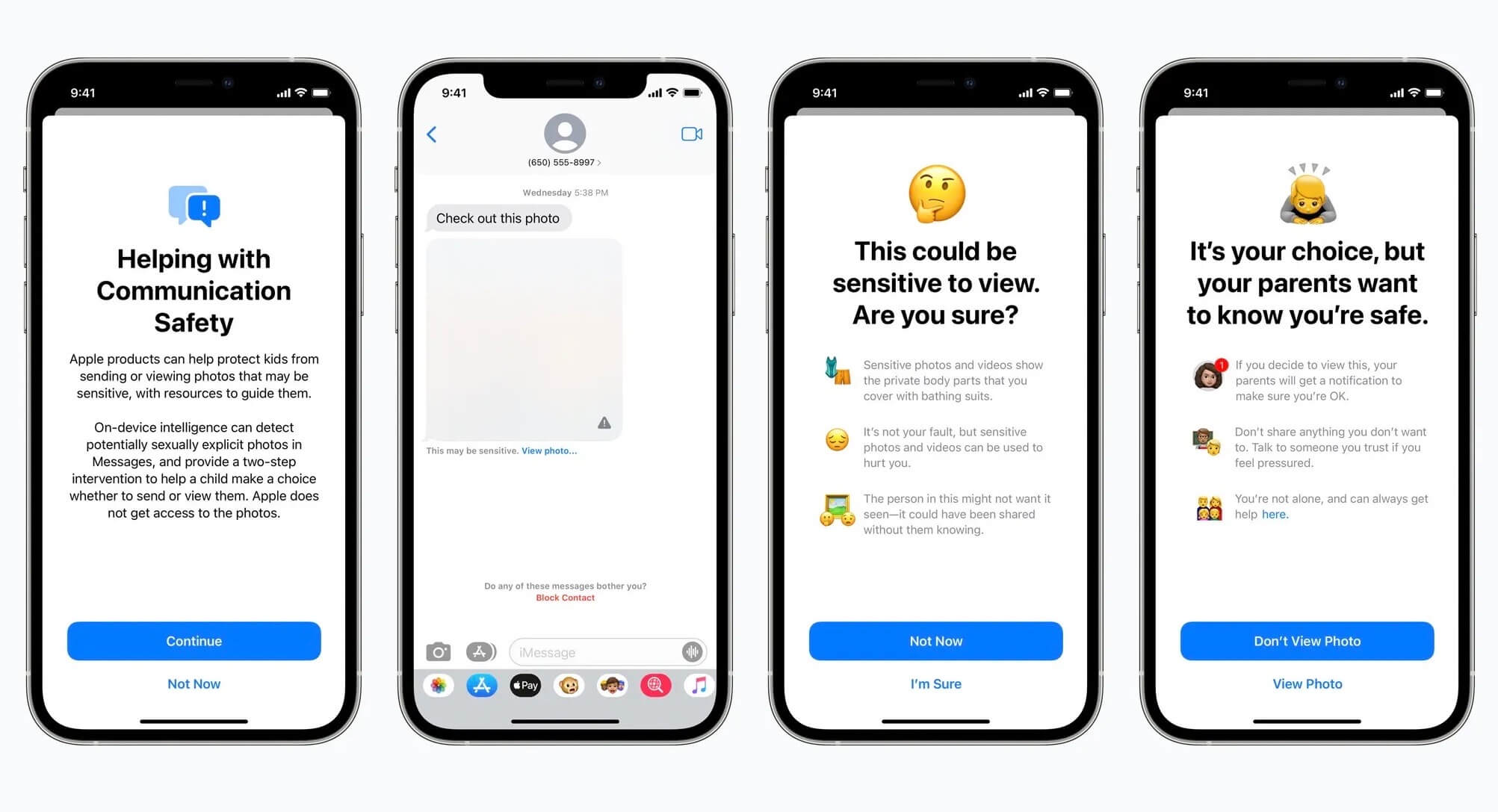

Apple hatte vor drei Jahren eine Technologie zur Erkennung von CSAM angekündigt, die Fotos auf iPhones lokal scannen sollte. Nach massiver Kritik von Datenschützern wurde das Vorhaben jedoch aufgegeben, wie Apfelpage berichtete. Dies wird nun erneut kritisiert, da Apple im Vergleich zu Konkurrenten wie Google und Meta angeblich zu wenig in Schutzmaßnahmen investiert und nur wenige CSAM-Fälle meldet. Apple verweist hingegen auf den Nacktfilter in seinen Betriebssystemen, der pornografisches Bildmaterial automatisch unkenntlich macht.

9 Gedanken zu „Sammelklage: Apple tut zu wenig gegen Material von Kindesmissbrauch in iCloud“

Die Kommentare sind geschlossen.