Vor knapp 24 Stunden hat Apple die erste Beta von iOS 13.2 für Entwickler freigegeben. Mit dabei: Deep Fusion als Kamerasoftware für die iPhone 11 und iPhone 11 Pro. Wir haben das Ganze für euch schon kurz getestet.

Vorneweg zwei, drei Dinge:

- Dies ist ein Minitest, ein umfänglicher wird noch folgen

- Das Ganze ist noch in der Beta, oder zumindest Teil einer Beta, könnte also noch besser werden

- Deep Fusion funktioniert vermutlich besser bei Porträts und Personen

- Die Ergebnisse sind also noch nicht final und liefern nur einen ersten Eindruck

Leider gibt es im Moment einige Tester, die iPhone X, Xr oder Xs Aufnahmen mit Deep Fusion auf den neusten iPhone 11 Modellen vergleichen. Doch dieser Vergleich hinkt ja vorne und hinten. Auf den ersten Blick sieht Deep Fusion so nämlich nach einem richtig heftigen Schritt aus, wobei man aber nicht trennen kann, was an der iPhone 11 Kamera, und was tatsächlich an Deep Fusion liegt. Das betrifft zum Beispiel den Vergleich von Tyler Stalman, der heute damit groß in den Medien war:

Unsere Bilder

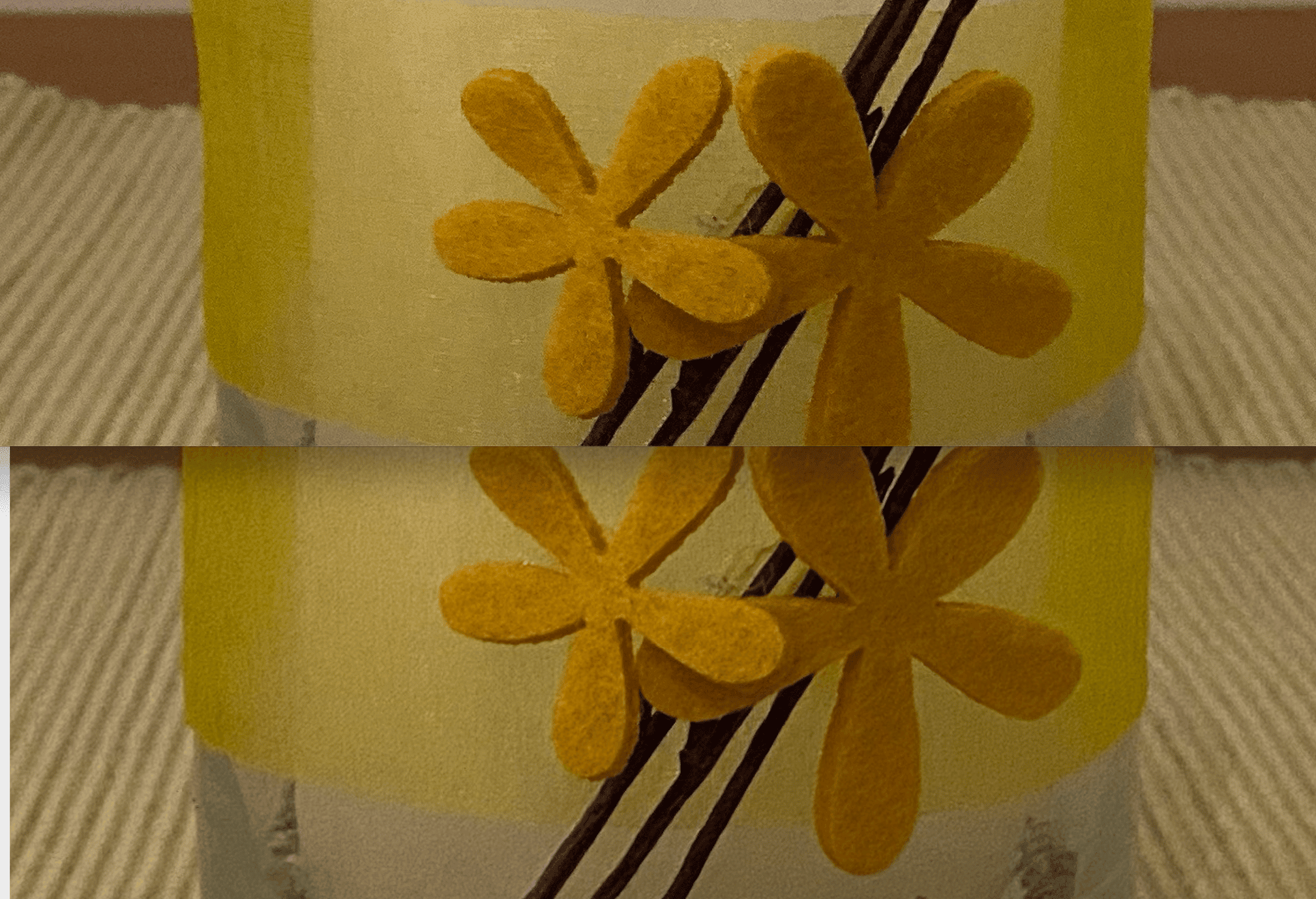

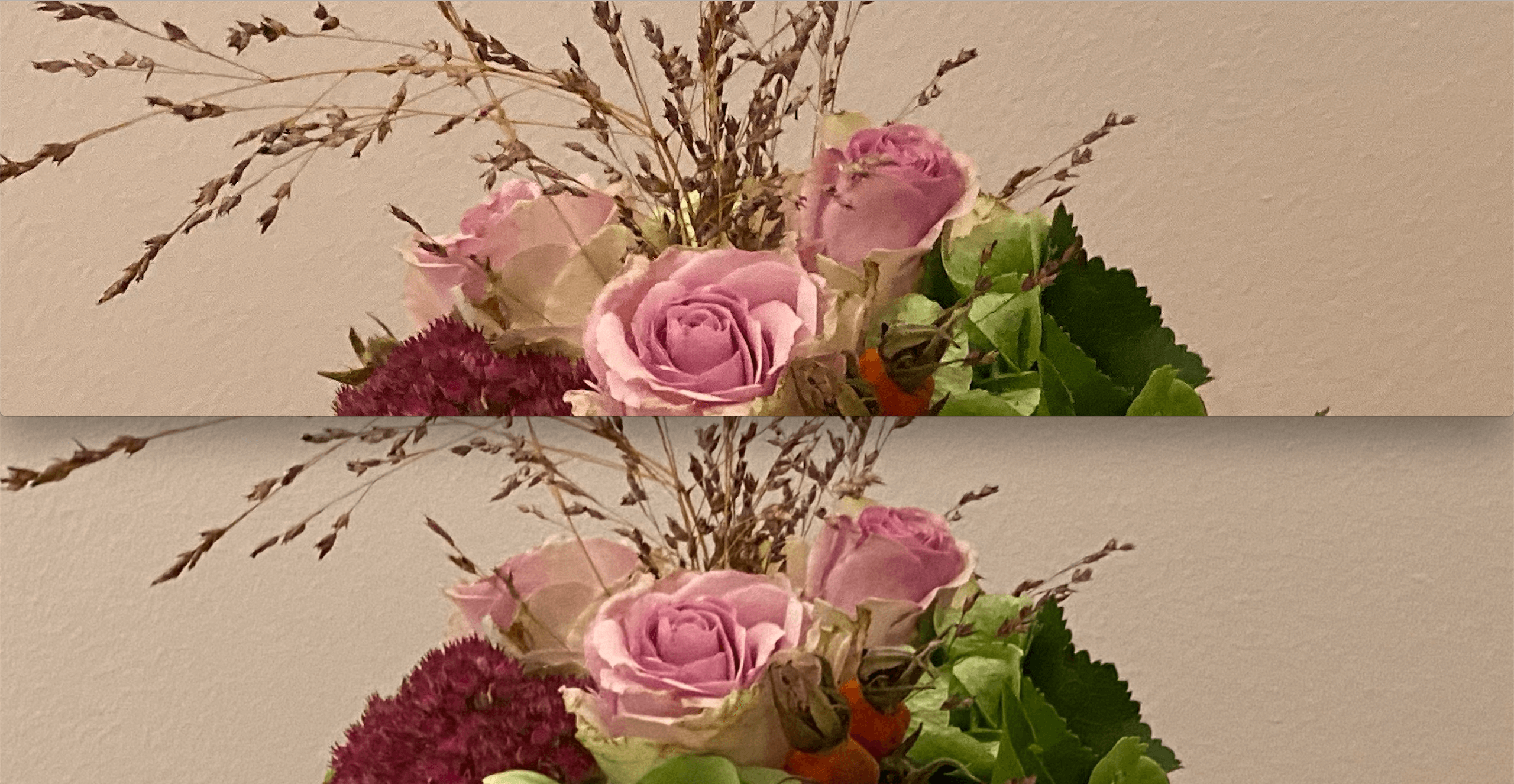

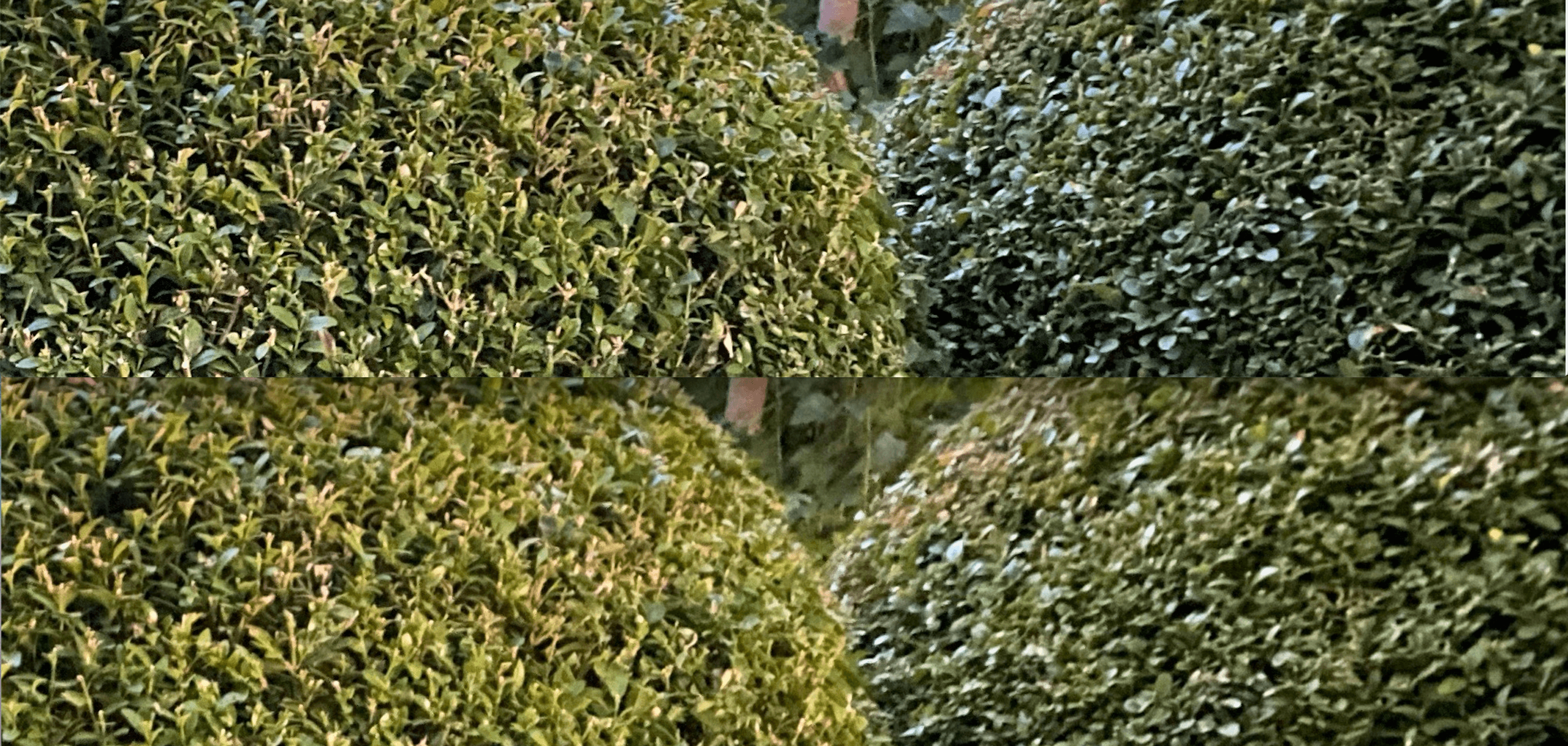

Ich hab in den heutigen Abendstunden einige Bilder mit einem iPhone 11 Pro mit iOS 13.2 Beta 1 und Deep Fusion und einem iPhone 11 Pro mit iOS 13.0 gemacht. Würde ich die Bilder hier groß reinziehen, würdet ihr kaum einen Unterschied erkennen. Ich habe die Fotos also deutlich vergrößert und übereinander gelegt.

Und tatsächlich, der Unterschied ist deutlich zu erkennen. Auf einem großen Computerbildschirm braucht man dafür keine Brille. Die Bilder mit Deep Fusion sind durch die Bank deutlich schärfer, haben bessere Farben und können gerade bei feinen Strukturen wie etwa Pullover, Stoff, Blumenumrisse, Gräser etc. überzeugen. Schaut selber einmal:

Hier ist die Struktur des gelben Bandes auffällig. Deep Fusion fängt diese horizontalen Linien ein, unter iOS 13.0 ist es ein gelber Match. Auch die Umrisse der gelben Stoffblumen sind oben deutlich besser.

Auf diesem Bild könnt ihr einmal die Strukturen in der roten Blume ganz links unten vergleichen sowie die Wedel darüber.

Hier auch nochmal schön zu sehen: Die Strukturen in diesem Buchsbaum sind oben klar und deutlich erkennbar, während sie unten teilweise schwammig und matschig wirken. Beide Bilder wurden übrigens mit dem Nightmode gemacht.

Übrigens: Man sieht nach der Aufnahme wirklich nicht, ob das Bild mit oder ohne Deep-Fusion-Prozess gemacht wurde. Und man kann das Zeug beim Aufnahmen weder aktivieren noch deaktivieren. Das einzige, was sichtbar ist: Direkt nach dem Aufnehmen wird ein Platzhalter-Bild ohne Deep-Fusion-Processing in den Aufnahmen gespeichert, welches bei direktem Ansehen nach knapp einer Sekunde mit dem Deep-Fusion-Bild ersetzt wird.

Keine Revolution

Doch man muss schon genau hinsehen. Und damit sind wir beim Punkt und meinem kurzen Fazit angelangt: Deep Fusion ist keine Revolution wie Apple es gerne hätte, aber nochmals ein deutlicher und merkbarer Schritt besser als die bisherigen Bilder auf dem iPhone 11 Pro. Und diese waren ja schon besser als im Xs und deutlich besser als im X! Deep Fusion Bilder sind zusammen mit dem Nachtmodus und allen iPhone-11-Verbesserungen also besonders im Vergleich zu den Vorgänger-iPhones wirklich erstaunlich gut.

Die Software wird also tatsächlich den kleinen aber feinen Unterschied machen, und das iPhone 11 Pro endgültig zur besten Handykamera werden lassen, die es im Moment und vermutlich die nächsten Monate auf dem Markt geben wird. Einmal abgesehen davon, dass es sich hier noch um eine Beta handelt!

Wir werden beim öffentlichen Release von iOS 13.2 vielleicht nochmals einen ausführlicheren Bericht publizieren. Das hier war tatsächlich nur flüchtig und sollte eher als Minitest verstanden werden.

11 Gedanken zu „Deep Fusion im Minitest: Wie groß ist der Unterschied?“

Die Kommentare sind geschlossen.